鱼来自奥菲庙。

量子比特报告|微信官方账号QbitAI

深度神经网络往往存在过拟合的问题,这就需要正则化方法的加持,如丢弃、权重衰减等。

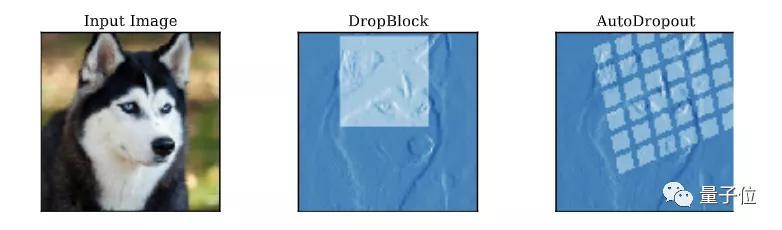

然而,最近的研究表明,如果使用由辍学“切断”的神经元的结构,它可以获得比随机替换更好的结果。

问题是,在实际应用中,对于不同的问题,使用结构的方法需要手工设计,调整漏失的模式,因此泛化能力不足。

那么,我们是否可以为CNN和Transformer等深度神经网络设计一种自动学习辍学模式的方法呢?

现在,谷歌大神Quoc V. Le的团队提出了一种方法,叫做AutoDropout。

篇相关论文入选AAAI 2021。

篇相关论文入选AAAI 2021。

将设计Dropout模式的过程自动化

AutoDropout的主要用途是自动设计特殊场景的Dropout模式。

研究人员设计了一个新的搜索空间的结构辍学模式。这个搜索空间包括许多现有的辍学模式。

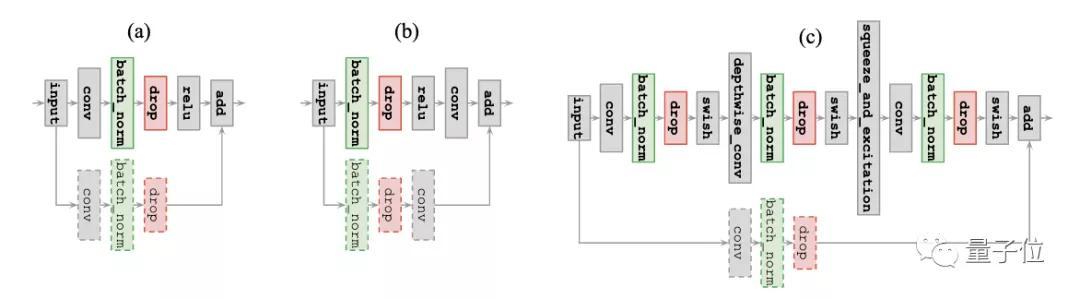

我们以CNN为例,看看这种方法是如何实现的。

CNN中的Dropout模式搜索空间

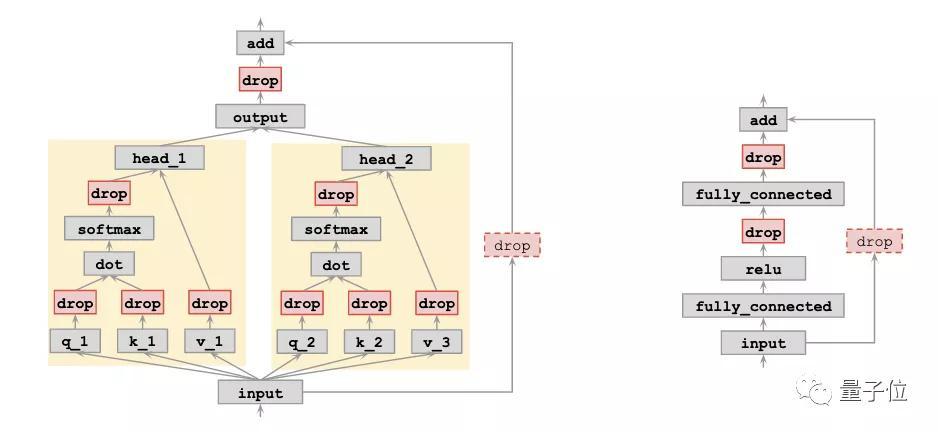

在CNN中,搜索空间的基本模式是一个连续的矩形。当矩形平铺时,它将产生一个脱落图案。

定义矩形的超级参数,即高度和宽度;定义平铺的超参数是步幅长度和重复次数。

除了平铺矩形,还需要在搜索空间中引入两种几何变换:绕空间中心旋转和沿每个空间维度切割。

除了平铺矩形,还需要在搜索空间中引入两种几何变换:绕空间中心旋转和沿每个空间维度切割。

在获得脱落模式后,研究人员将其应用于批处理规范化层的输出——。根据研究人员的经验,将其应用于网络的其他部分往往会导致搜索过程中训练的不稳定性。

如果CNN中存在剩余连接,控制器将进一步判断是否对剩余差分支应用dropout模式。

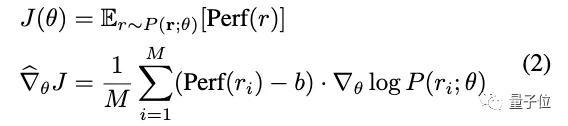

控制器模型和搜索算法

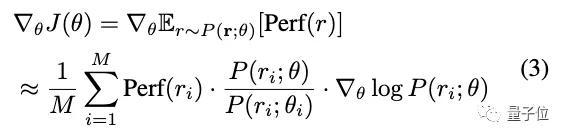

自动辍学控制器通过强化学习进行训练。

控制器其实就是一个变压器网络。网络生成令牌来描述丢弃模式的配置。

控制器其实就是一个变压器网络。网络生成令牌来描述丢弃模式的配置。

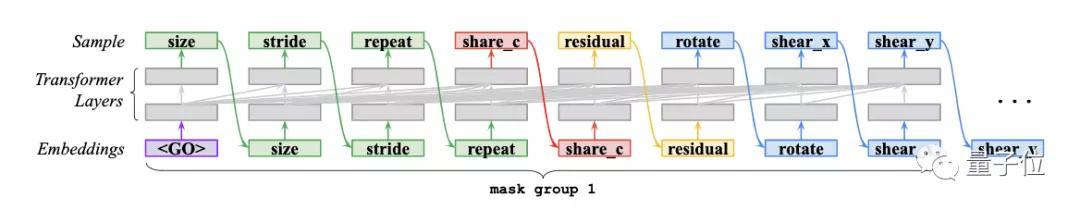

如下图所示,对于CNN中的每一层,需要8个令牌来创建丢失模式。

然而,这种搜索算法可能需要大量的时间来训练,因此研究人员也在并行性方面进行了改进。

然而,这种搜索算法可能需要大量的时间来训练,因此研究人员也在并行性方面进行了改进。

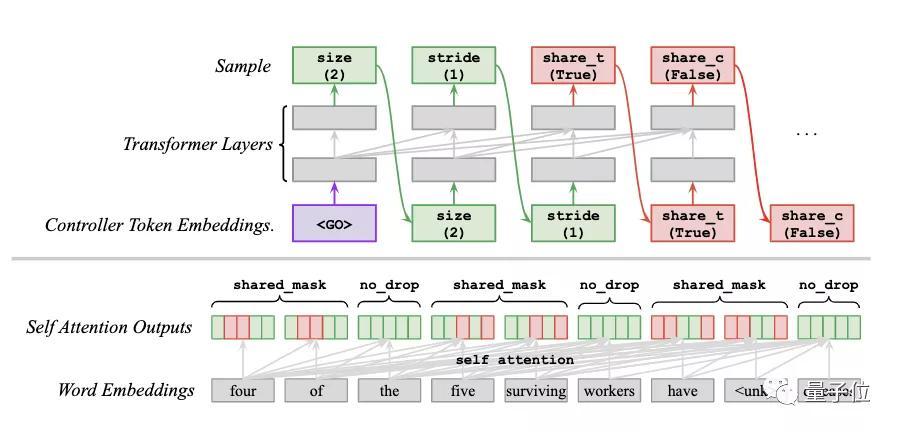

Transformer中的Dropout模式搜索空间

该方法也适用于变压器。

与CNN最大的区别在于,搜索空间中的dropout模式可以灵活地应用于Transformer层的多个子层,如query、key、value、softmax、output projection和residual。

与CNN最大的区别在于,搜索空间中的dropout模式可以灵活地应用于Transformer层的多个子层,如query、key、value、softmax、output projection和residual。

因此,研究人员对每个子层应用了独立的辍学模型。

实验结果

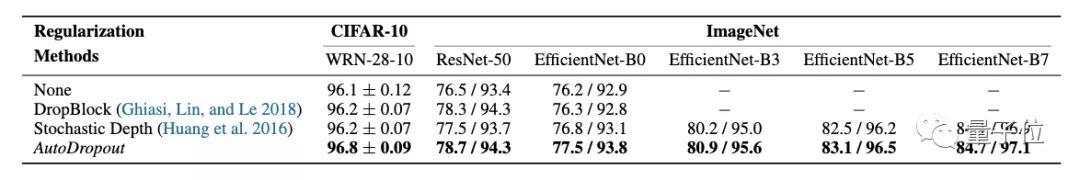

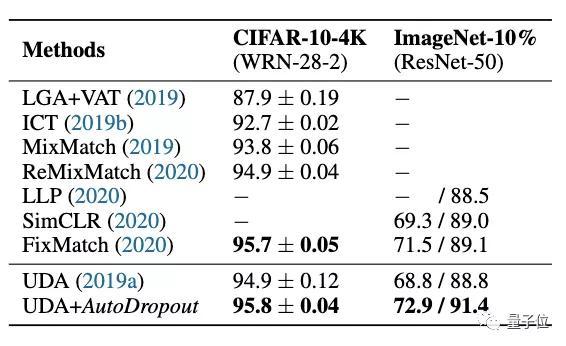

为了验证自动退出的效果,研究人员分别在CNN和Transformer模型中应用了自动退出。

对于CNN,主要用于监督图像分类任务和半监督图像分类任务。

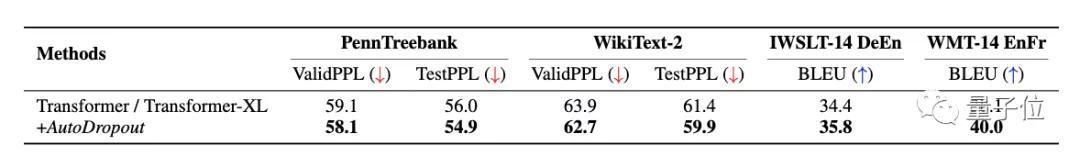

对于Transformer,我们主要考虑语言模型和机器翻译。

可以看出,在CIFAR-10和ImageNet上,AutoDropout都有效地改善了SOTA模型的结果,并且优于DropBlock等需要人工干预的方法。

可以看出,在CIFAR-10和ImageNet上,AutoDropout都有效地改善了SOTA模型的结果,并且优于DropBlock等需要人工干预的方法。

与用变分丢弃法训练的Transformer-XL模型相比,AutoDropout也带来了更好的性能。

然而,研究人员也提到了自动辍学的缺点是搜索成本高。

然而,研究人员也提到了自动辍学的缺点是搜索成本高。

有关作者

本文有两位作者。

谷歌大脑和卡内基梅隆大学联合培养的博士生Hiepham毕业于斯坦福大学。

另一位作者是大哥郭诉乐。他是吴恩达的学生,谷歌大脑的创始人之一,谷歌AutoML项目背后的英雄之一。

另一位作者是大哥郭诉乐。他是吴恩达的学生,谷歌大脑的创始人之一,谷歌AutoML项目背后的英雄之一。

传送门

论文地址:

https://arxiv.org/abs/2101.01761

—结束—

量子qbitai头条号签约

关注我们,第一时间获悉前沿科技动态。